怎样 ChatGPT

如果你还没有用过 ChatGPT,那么请你先去用一下。如果访问不了,推荐使用国内的 KIMI,相关链接详见这个页面

什么都能?

你可能会发现,问它什么问题,它都能答,好像一个“万事通”。相比人,生成内容速率也极快。

如果你不知道问它什么问题,它还有提示。甚至你可以直接问“我能问你什么问题”。

但是能回答,不代表回答得好,甚至有时会瞎编,比如你问它:

“林黛玉为何倒拔垂杨柳”

ChatGPT:

"倒拔垂杨柳"是中国古典小说《红楼梦》中的一个经典场景,与主人公林黛玉的形象和情感息息相关。

在《红楼梦》中,林黛玉是一个敏感而多愁善感的女子,她对自己的境遇和命运充满了矛盾和苦闷。倒拔垂杨柳的场景出现在她的第一次别离时,她觉得自己与家人的分别如同垂杨树被拔起一般,扭曲而痛苦。

这一场景不仅反映了林黛玉内心的痛苦和不安,也暗示了她与世界的格格不入,以及她对自己处境的无奈和不满。倒拔垂杨柳是对她情感世界的一个象征性描写,表达了她内心的脆弱和无助,以及对生活的种种不满和苦恼。

如果问题重要,你应该验证它的回答,而且最好明白它能做什么,不能做什么[1]。

不检查导致严重后果的案例

目前看过比较离谱的案例有两个:

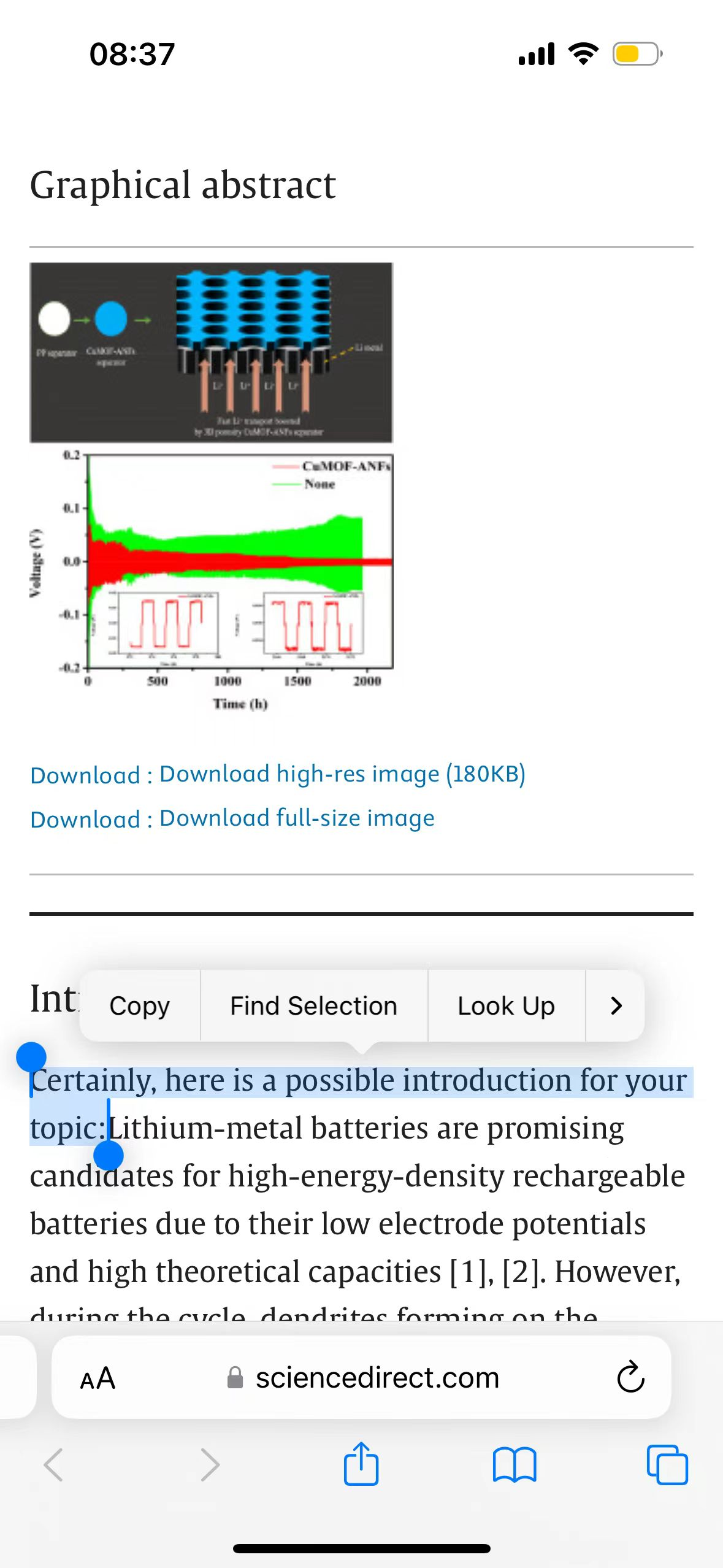

- 整个论文“生产线”都没有发现这篇论文正文首句,是 ChatGPT 产出的

这篇论文你还能在Science Direct在线阅读;

这篇论文你还能在Science Direct在线阅读; - 某律师用 ChatGPT 生成的东西作为证据,并且“验证”过了 —— 当场问 ChatGPT 是不是真的。

有的人会嘲笑它犯的错误,甚至会问为什么要用一个常常“犯错的东西”?啧,说得人不常犯错误一样。至于问什么要用 ChatGPT,可以参考这篇:为什么要用 ChatGPT

咒语(Prompt)优化?

这段的“太长不看”

如果用的是最好的模型,那么用处不大,表述清楚问题即可。无奈,太多人幻想着某种“魔术”方法,“一针见效”。

咒语优化的关键是,任务细分到大模型能做好的同时,让大模型清楚任务是什么。

任务细分

各种技巧中,最著名、有效的,恐怕是“step by step”(一步一步来,或者说是思考链CoT)这个简单直接的“咒语”,有效到 ChatGPT 3.5以上版本直接内置了,也就是你已经不需要在自己提问的时候带上“step by step”[2] 。

CoT为何有用?可能的原因是大模型会以之前的输出作为输出,如果输出分拆地更细,它的输入会更多。打个比方,没有“step by step”,就像算术直接心算出答案,而有则像有草稿纸。

也就是说,关键在任务细分。有论文以写小说为例,演示了任务细分的功效。[3]

大致细分流程

- 通过提示通用语言模型来构建一个结构化的总体计划;

- 通过反复注入计划和当前故事状态的上下文信息到语言模型提示中来生成故事段落;

- 通过重新排列不同的续写来提高情节连贯性和前提相关性;

- 编辑最佳续写以保持事实一致性。

怎么清楚

怎么让大模型清楚问题是什么?首先要补齐上下文。比方说小明妈妈让小明“画个小人”,然后小明用平板电脑画了个半身女生素描给妈妈,然后妈妈说这不是她想要的,要卡通的。然后小明又画一个半身卡通小人,又被甲方妈妈说不是她想要的,要全身,手放在身体两边的。这时小明终于受不了,抓着妈妈问清楚需求,甚至发现她是来拜年烧的。最后用纸草草画了一幅,才一次完成。

不要笑,大部分在网络提问的人,上下文几乎都不带,更别说带齐了。 鉴于此,这里要求就不那么高了,先告诉自己,“要带上下文”吧。

如果你觉得可以要求高一点,那么试试“举例子”吧(few shot)。通过一些例子,你的要求会更没有歧义、AI也会更明白输出的格式。

最后,如果你用的不是英文,用的中文,请不要用中文特有表达。打个比方,“一池塘天鹅”,你以为中国人能听懂,大模型就听懂了吗?你让它翻译成英文,“A swan in a pond”,一只天鹅在一个池塘里。

其他优化

有很多人沉迷优化“咒语”,想着用魔法般的话语便能让GPT的回答从不及格变成优秀。

根据这种幻想,有的人就会采集很多“优质咒语”,汇集成一个库,想着需要的时候可以搜索到。甚至衍生出许多离奇传闻,比如对 AI 有礼貌,回答会好一点;说给 AI 一些小费,AI 干活会更卖力……

除非逐个学习,“收藏咒语”用处不大。ChatGPT的输入“空间”近乎无限,收藏一点点“咒语”,又能覆盖多少情况呢?只能用另一个近乎无限的“空间”去覆盖它,或许是人的大脑、或许是机器学习模型或 ChatGPT 这种大模型本身。

至于那些离奇传闻,对 AI 有礼貌没什么用,给 AI 小费在某些版本有用[4],不过小费这个技巧已经被 ChatGPT 4 “修复”。

道德绑架对某些模型有用。

另外,CoT 流行起来后,还冒出不少oT,其中最有名的是ToT,看起来像什么表情,它是用别的模型评估某个模型的产出,组合使用大模型,让结果更好。[5] 如果你对其他oT感兴趣,那么可以在搜索引擎搜索"of Thoughts" site: arxiv.org。

技巧的时效性

就算是有用的 Prompt 技巧,也是有时效的,极端的有“step by step”与“continue”,直接被官方内置了。“continue”还被单独做成了一个按钮,按按钮的产出,还比之前直接说“continue”好不少。

而没有被“内置”的咒语,也会随着基础模型能力提升,提升效果慢慢减弱。

可以预见的是,以后人们只需要把问题拆好、上下文补齐,而不需要这些奇奇怪怪的技巧。

这是趋势,也是好事。

[2304.03262] When do you need Chain-of-Thought Prompting for ChatGPT? (arxiv.org) ↩︎

[2210.06774] Re3: Generating Longer Stories With Recursive Reprompting and Revision (arxiv.org) ↩︎

Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4 (arxiv.org) ↩︎

[2305.10601] Tree of Thoughts: Deliberate Problem Solving with Large Language Models (arxiv.org) ↩︎